VI. Annexe 1▲

|

Société |

ETL |

Commentaire |

|---|---|---|

|

Abinitio |

Abinitio |

|

|

Altova |

Mapforce |

|

|

Attunity |

Integration Suite |

|

|

Barracuda software |

Barracuda Integrator |

|

|

Benetl |

Benetl |

Freeware |

|

Business Objects |

Data Integrator |

|

|

Cast Iron Systems |

Cast Iron Integration Appliance |

|

|

CA |

Data integrator |

|

|

OpenSys |

Clover ETL |

open source |

|

Cognos |

Decisionstream |

|

|

Corporator |

Transformer |

|

|

CoSORT |

CoSORT ETL tools |

|

|

Crossflo Systems |

DataExchange |

|

|

Datacyr Corporation |

DataCyr Transform |

|

|

Data Exchanger |

Data Exchanger |

|

|

DataHabitat |

DH ETL |

|

|

Datamirror |

Datamirror |

|

|

D2K |

D2K |

|

|

Embarcadero |

DTStudio |

|

|

Enhydra |

Octopus |

open source |

|

ETL Solutions ltd |

Transformation Manager |

|

|

ETI |

ETI Solution |

|

|

GammaSoft |

data'distribution |

|

|

Group 1 |

Data Flow |

|

|

Hummingbird |

Genio |

|

|

Information Builders |

iWay |

|

|

IBM |

Websphere DataStage |

|

|

Ikan |

MetaSuite |

|

|

Informatica |

PowerCenter |

Market leader |

|

iSoft |

Amadea |

|

|

Microsoft |

DTS |

Ceased to exist |

|

Microsoft |

Integration Services |

Bundled with SQL server |

|

Oracle |

Warehouse Builder |

|

|

Oracle |

Sunopsis |

|

|

Pentaho |

Pentaho Data integration |

open source |

|

Pervasive |

Data Junction |

|

|

Pervasive |

Data Integrator & Business Integrator |

|

|

Platinum |

Info Pump |

Acquired by CA. |

|

Powershift |

Manheim |

|

|

Sagent Technology |

Sagent Solution |

Acquired by Group 1 |

|

SAS |

Data integration |

Previously ETL/Studio |

|

Solonde |

Warehouse Workbench |

Acquired by Sybase |

|

Sterling Commerce |

Gentran Integration Suite |

|

|

Sunopsis |

Data Conductor |

Acquired by Oracle |

|

Sybase |

Data Integration Suite & Data Federation |

|

|

Syncsort |

DMExpress |

|

|

Talend |

Talend Open Studio |

open source |

|

WisdomForce™ |

FastReader |

VII. Annexe 2▲

VII-A. Un besoin et un projet client▲

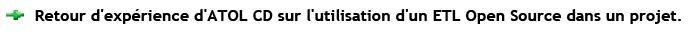

En 2007, en lien direct avec l'explosion des cours des céréales, il a été décidé de mettre en place un service en ligne de « Bourse aux céréales » afin de permettre aux céréaliers d'avoir un minimum de garanties concernant les prix de vente et d'achat des céréales.

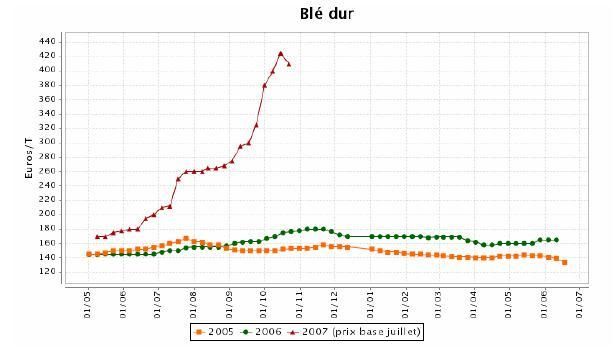

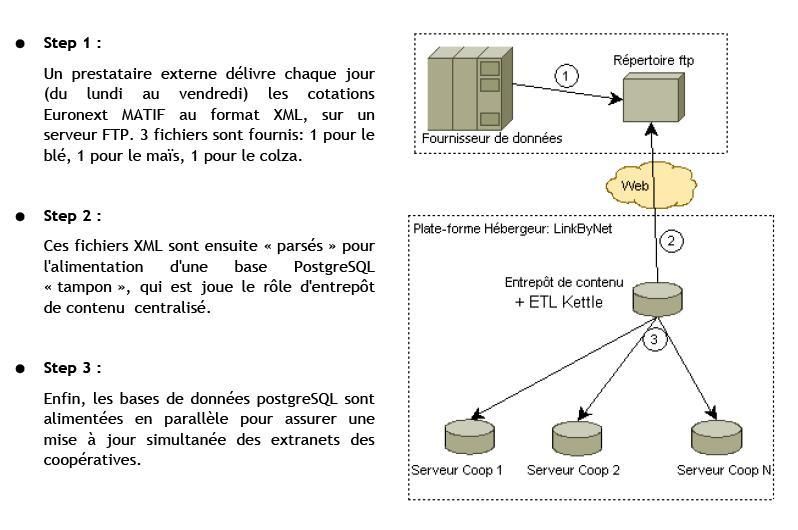

C'est dans ce contexte que l'ETL Pentaho Data Integration a été mis en place pour récupérer les cotations EuroNext MATIF du blé, du colza et du maïs, et ainsi permettre une mise à jour quotidienne des services de bourse disponible sur une trentaine d'extranets.

VII-B. Mise en place technique▲

La syntaxe des fichiers XML à traiter est la suivante :

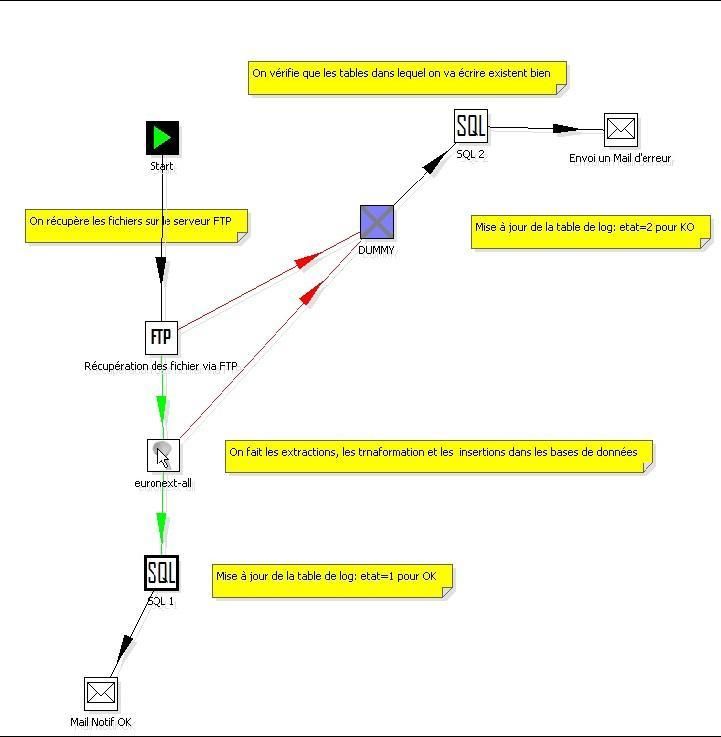

Le job permet :

- de récupérer par FTP les fichiers XML ;

- de lancer le traitement et l'intégration des données dans l'entrepôt central ;

- de notifier par mail le bon déroulement (ou non) des traitements ;

- d'exécuter des ordres SQL pour indiquer à l'application l'heure des traitements et le bon déroulement de ceux-ci.

- Détail du job du step 2 :

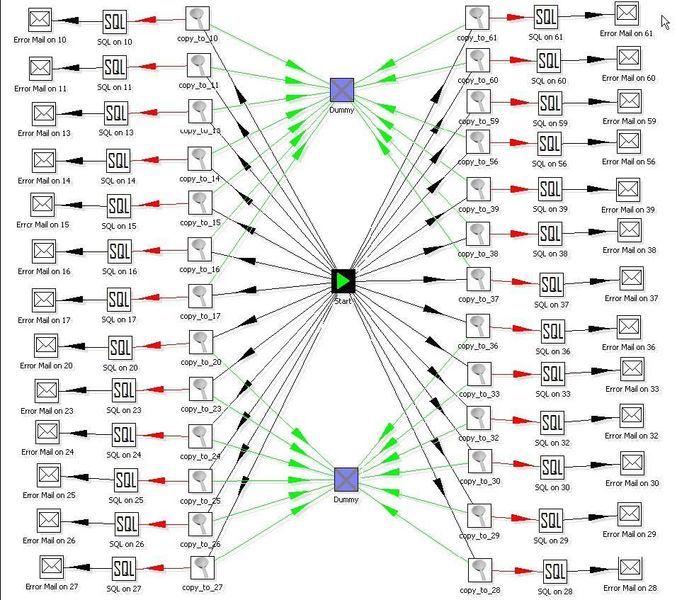

- Détail du job du step 3 :

Mise à jour en parallèle des 30 serveurs extranets :

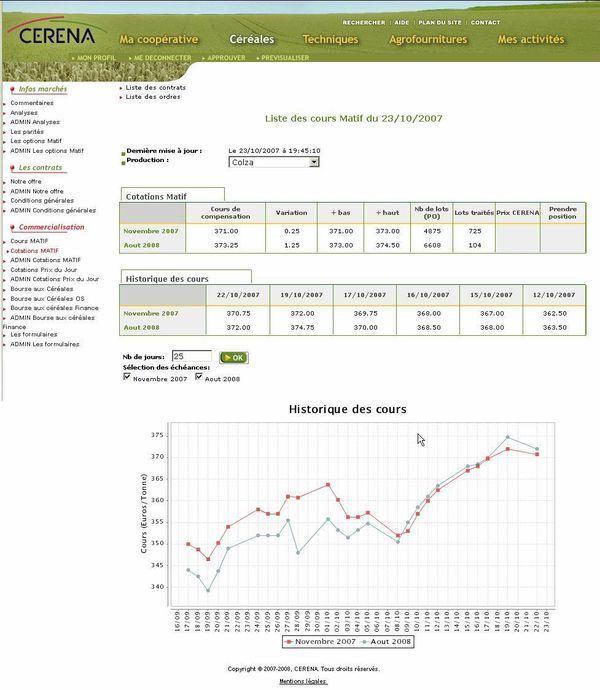

VII-C. Résultat sur un extranet▲

Le résultat du traitement d'intégration de données permet de visualiser quotidiennement à partir de 19h45 les cours de clôture du MATIF sur chacun des extranets.

Les données sont présentées de façon tabulaire et graphique :

VII-D. Feedback sur l'utilisation de « Pentaho Data Integration »▲

Dans ce contexte métier très précis, voici les éléments que l'on peut retirer de l'utilisation d'un ETL open source :

- Phase de Conception/Développement :

L'utilisation de Pentaho Data Integration est très simple et intuitive, il n'y a pratiquement aucun code à écrire pour la conception et la définition des traitements d'intégration.

Il y a donc des gains conséquents en terme de développement, malheureusement on ne peut pas s'affranchir de l'analyse (!)

La documentation, les « samples » fournis avec l'outil et le site de Pentaho Data Integration (kettle.pentaho.org) permettent bien souvent de trouver la solution à un point de blocage.

Les fonctions de prévisualisation de l'ETL permettent de tester efficacement les traitements lors de la phase de développement.

- Phase d'installation :

Il suffit d'installer Pentaho Data Integration sur le serveur cible (décompression d'un zip, installation de java 1.5 si besoin), puis ensuite de planifier les traitements batch (via crontab sous Linux).

Le déploiement des jobs peut se faire par recopie du « repository » de DEV sur le serveur de PROD (remontée du dump de la bdd du repository kettle)

- Phase de production :

Chaque jour, les mails de notification permettent d'être informés du bon déroulement des traitements.

À ce jour, aucun « plantage » n'a été constaté depuis la mise en production effectuée le 23 mai 2007.

- Maintenance :

La maintenance évolutive ou corrective est grandement simplifiée du fait de la vision graphique des traitements et du découpage de ceux-ci en briques élémentaires.

Si jamais un jour il faut aller chercher les données via webservice, il suffira de remplacer l'étape « parsing XML » par un «webservice call »

- Coûts de licences :

Aucun